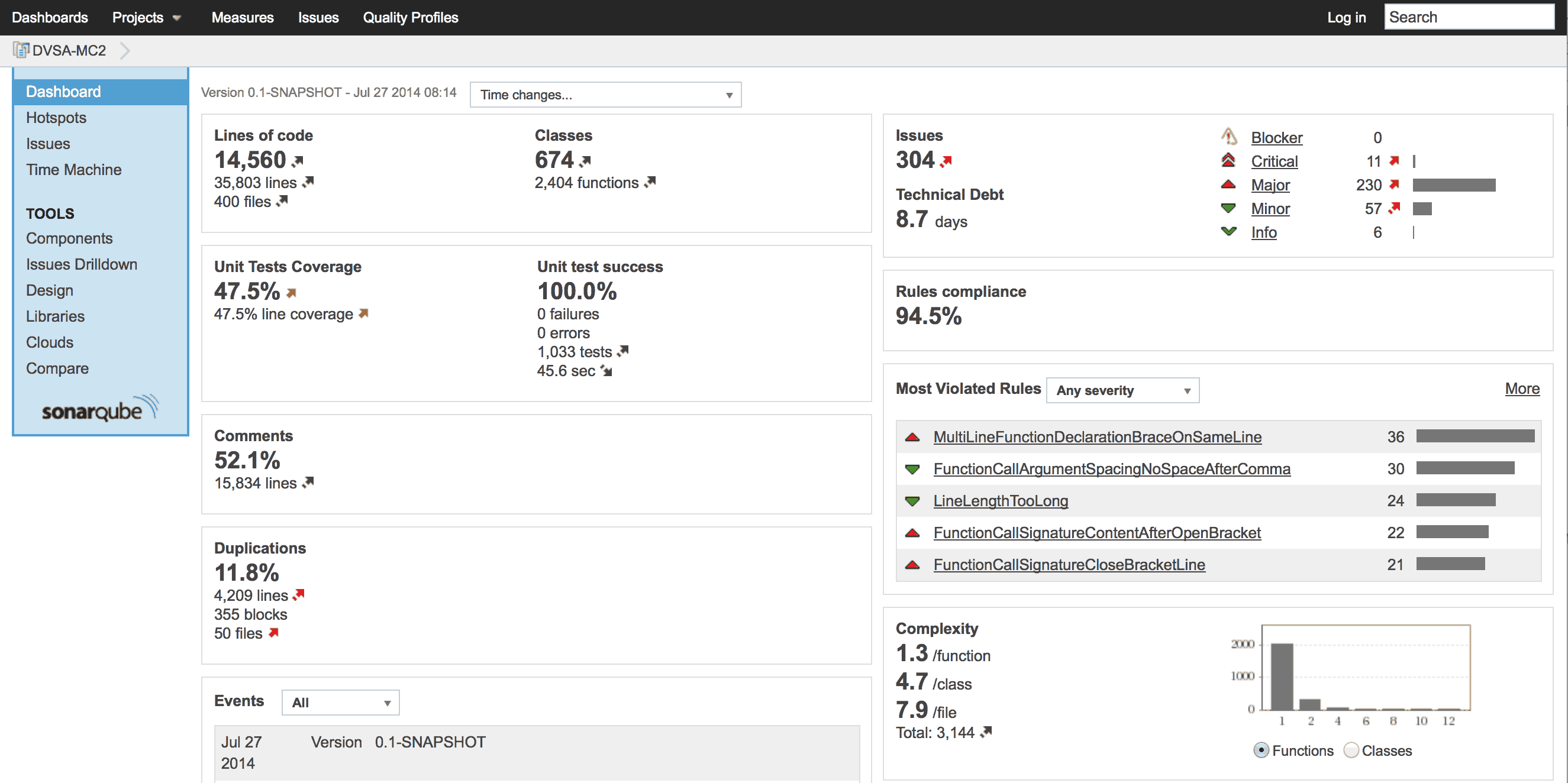

La Arquitectura de Software es central en la estrategia de las organizaciones que basan su negocio en el uso intensivo de la tecnología. Sus atributos de desplegabilidad y testabilidad son …

Continue Reading acerca de Diagnóstico de Arquitectura de Software Basado en Experto →